Jak zadbać o skalowalność danych?

Do wykorzystania swojego potencjału AI potrzebuje dostępu do stale rosnących zasobów informacji, co wiąże się ze zwiększeniem wolumenu danych. Dlatego trzeba zapewnić ich skalowalność. Jak o nią zadbać od początku projektu IT? Dzielimy się naszymi sprawdzonymi metodami!

Kiedy mówimy o skalowaniu danych, często myślimy przede wszystkim o tym, jak pozyskiwać ich więcej. To prawda – skalowalność danych może oznaczać, że rozszerzamy liczbę źródeł, z których je zbieramy. Ale to tylko jedna strona medalu. Druga dotyczy tego, co dzieje się z tymi danymi dalej – jak je przetwarzamy, analizujemy, prezentujemy i wykorzystujemy, np. przez agentów AI. I tu właśnie pojawia się potrzeba skalowalności infrastruktury i oprogramowania.

Spis treści

- Czym jest skalowalność danych?

- Dlaczego skalowalność jest ważna?

- Jak na skalowalność wpływa konteneryzacja?

- Dlaczego skalowalność zaczyna się już na etapie projektowania aplikacji?

- Czy analityka może sparaliżować bank? (I jak temu zapobiec dzięki replikacji?)

- Jak hurtownia danych pozwala zobaczyć to, czego nie widać w systemie produkcyjnym?

Czym jest skalowalność danych?

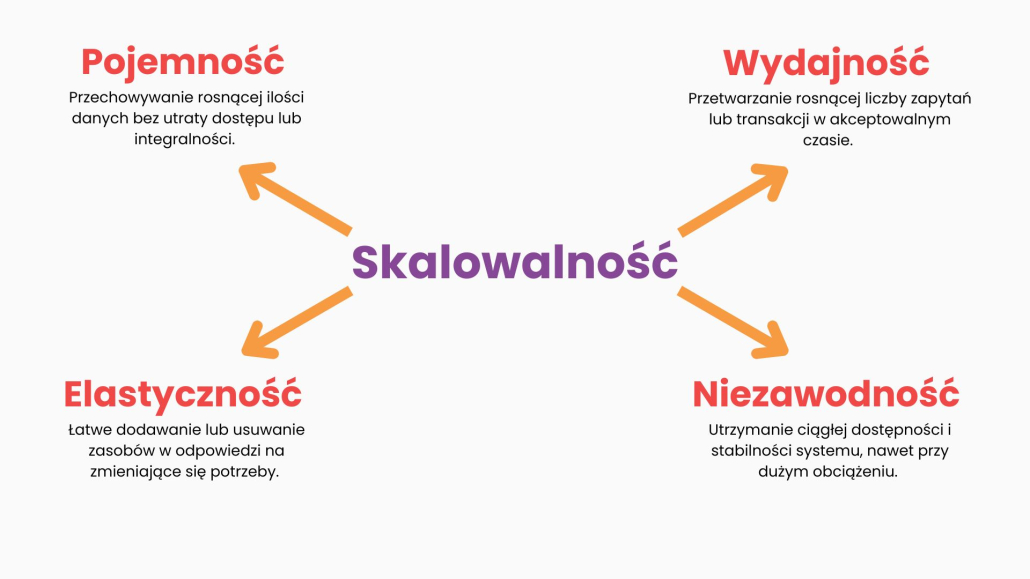

Skalowalność danych to zdolność systemów do efektywnego zarządzania rosnącą ilością danych. Oznacza to, że system działa szybko i sprawnie, nawet gdy danych przybywa – bez potrzeby kosztownych zmian technicznych.

Dobre zarządzanie danymi jest ważne. Pomaga zadbać o to, by dane były dostępne, bezpieczne, przydatne i zgodne z przepisami. Skalowalność danych to jednak nie wszystko. Jak zadbać o kluczowe dane w erze AI, przeczytasz w artykule: „Jak przygotować dane na erę AI?”.

Dlaczego skalowalność jest ważna?

Pomyśl o danych Twojej firmy jak o zasobach, które rosną wraz z Twoim biznesem. Jeśli w Twojej firmie przybywa klientów, transakcji czy monitorowanych parametrów produkcyjnych, ilość danych w pamięci podręcznej gwałtownie wzrasta. Systemy, które nie są skalowalne, w pewnym momencie przestaną efektywnie przetwarzać i przechowywać te informacje. Mogą działać wolno, zawieszać się, a nawet przestać działać. To może oznaczać straty finansowe i utratę zaufania klientów.

Skalowalność pozwala na elastyczne reagowanie na potrzeby firmy i rynku. Skalowalne systemy to inwestycja w przyszłość firmy, która otwiera drzwi do innowacji i przewagi konkurencyjnej. Dlaczego jest ona tak istotna?

- To fundament dynamicznego wzrostu, który pozwala na bezproblemową obsługę rosnącej liczby klientów i operacji. Firmy mogą płynnie rozszerzać swoją działalność i pokonywać technologiczne bariery.

- To solidna podstawa dla zaawansowanych narzędzi analitycznych i sztucznej inteligencji. One napędzają innowacje – dostarczają cenne informacje i umożliwiają automatyzację procesów.

- To klucz do sprawnego funkcjonowania firmy i zadowolenia klientów. Zapewnia utrzymanie optymalnej wydajności systemów, nawet przy lawinowo rosnącej ilości danych.

Skalowalne systemy charakteryzują się elastycznością. To one umożliwiają szybkie dostosowanie się do dodatkowych zasobów oraz zmieniających się wymagań biznesowych i technologicznych. Dzięki temu dają firmie przewagę w dynamicznym świecie.

Konteneryzacja kluczem do skalowalności

Pracujemy właśnie nad aplikacją, która skanuje portale z ogłoszeniami o pracę i tworzy z tego statystyki – ile ogłoszeń pojawia się i w jakim województwie, jakim mieście, w jakiej branży. Na początku skanujemy 2-3 portale – to już daje wartość naszemu klientowi. Ale jeśli zaczniemy skanować 10 czy 20 źródeł, to zyskamy nieporównywalnie większy obraz rynku. To właśnie skalowanie danych – rozszerzamy źródła, ale dane mają podobną naturę, więc możemy je agregować i analizować wspólnie.

Pozyskiwanie danych to dopiero początek

Im więcej danych zbierzemy, tym większe możliwości analizy i trafniejszego dopasowania wyników. Ale to oznacza też, że musimy poradzić sobie z ich objętością. Na przykład wcześniej wyszukiwaliśmy dwie interesujące oferty pracy spośród 100 tysięcy ogłoszeń, a teraz mamy ich milion. Nasze narzędzie musi więc być gotowe do przeszukania znacznie większego „stogu siana”, żeby znaleźć „igłę”. Czyli przetwarzanie większej ilości danych to też element skalowania.

Skalowanie danych wymusza skalowanie infrastruktury

Skoro rośnie liczba źródeł i objętość danych, musimy też zapewnić odpowiednie zasoby sprzętowe i odpowiednie narzędzia. Jeśli jedna aplikacja może skanować jeden portal naraz, to przy 20 portalach potrzebujemy równoległego działania wielu takich instancji. Inaczej obciążenie bazy danych będzie zbyt wysokie, a cały proces będzie trwał zbyt długo.

Tu z pomocą przychodzą konteneryzacja i orkiestracja. Dzięki kontenerom możemy „opakować” naszą aplikację w lekką, przenośną jednostkę. Przypomina ona wirtualny komputer, który zawiera wszystko, co jest potrzebne do jej uruchomienia. Gdy jeden kontener działa poprawnie, możemy go po prostu skopiować – bez instalowania wszystkiego od nowa. Tak jak kopiujemy pliki – copy-paste. Dzięki temu skalowanie o kolejne instancje jest szybkie, tanie i niemal natychmiastowe.

A gdy dodamy do tego system zarządzający kontenerami – tzw. orkiestrację – możemy zautomatyzować cały proces i uruchomić równolegle dowolną liczbę instancji. Zwiększamy więc zasoby w tempie, które odpowiada naszym potrzebom i możliwościom przetwarzania danych. To jest właśnie automatyczne skalowanie infrastruktury.

Na koniec – wszystko się łączy

Skalujemy dane – zbieramy ich więcej. Ale żeby miało to sens, musimy też skalować systemy, które je obsługują. Większa liczba danych to większa wartość, ale też większe wyzwanie. Dopiero połączenie skalowalności danych, infrastruktury i aplikacji daje efekt: szybkie, dokładne i wartościowe przetwarzanie danych, które odpowiada realnym potrzebom użytkowników.

Konteneryzacja: pudełko pełne oszczędności – CCA Europe.pl

Skalowanie aplikacji zaczyna się na etapie projektowania

Częstym błędem w tworzeniu aplikacji, zwłaszcza na wczesnym etapie projektu, jest skupienie się wyłącznie na jednym, konkretnym przypadku użycia. Takie podejście może działać w krótkim okresie. Na dłuższą metę prowadzi ono jednak do ciągłego dopisywania kolejnych funkcji i łatania rozwiązań. Z czasem może powstać system trudny do utrzymania.

Dobry, profesjonalny dostawca usług skalowania postępuje inaczej. Nie koncentruje się na jednym „use case”, ale już na etapie projektowania bierze pod uwagę co najmniej kilkanaście scenariuszy użycia. Dzięki temu tworzy on model danych czy architekturę systemu, które są bardziej elastyczne i gotowe na przyszłe rozszerzenia. Nie trzeba też w nich wprowadzać kosztownych przeróbek.

To trochę jak z budową domu. Jeśli zaczniemy od jednego pokoju, a nie mamy planu na całą resztę, może się okazać, że doprowadzenie wody do łazienki będzie później problematyczne. Trzeba będzie burzyć ściany, przerabiać instalacje i ponosić dodatkowe koszty. Tak samo w aplikacji. Na przykład model danych od początku nie przewidywał, powiedzmy, adresu pracodawcy, bo w pierwszych ogłoszeniach o pracę nie był on potrzebny. Przy kolejnym scenariuszu użytkownika może się jednak okazać, że musimy go dodać. A skoro stare dane go nie mają, trzeba ponownie przetwarzać cały zbiór, wracać do wcześniejszych rekordów i uzupełniać braki.

Im więcej takich poprawek, tym więcej czasu poświęcamy na „doganianie” poprzednich decyzji projektowych. Nie zajmujemy się jednak wtedy rozwojem produktu. Z czasem przetwarzanie danych staje się celem samym w sobie, a nie środkiem do osiągnięcia celu biznesowego.

Dlatego kluczem do skalowalności nie jest tylko odpowiednia infrastruktura czy technologia. To przede wszystkim sposób myślenia o projekcie – szeroki, elastyczny, uwzględniający przyszłe potrzeby i scenariusze. W erze danych i AI taka perspektywa to nie luksus, ale konieczność.

Replikacja bazy danych w bankowości

Bankowość to klasyczny przykład wymiany ogromnych ilości danych. Nawet nieduży bank w Polsce może mieć wielkie bazy klientów. Milion klientów – czyli milion wpisów tylko w tabeli z ich danymi. Każdy z nich ma zazwyczaj kilka rachunków, kartę debetową i kredytową oraz lokaty. To szybko przekłada się na kolejne miliony rekordów. Do tego dochodzą wyciągi, blokady, potwierdzenia, czyli kolejne dane generowane co miesiąc.

System bankowy musi te dane przechowywać, ale też na bieżąco obsługiwać: autoryzować płatności, naliczać odsetki, księgować transakcje. To często kilkadziesiąt tysięcy operacji na sekundę. Jednocześnie musi odpowiadać na zapytania analityczne, np. „przejrzyj 10 milionów transakcji i znajdź wzorzec”. W takim obciążeniu system zaczyna się dusić.

Dlatego wdraża się replikację bazy danych – czyli tworzenie wiernej kopii danych w czasie rzeczywistym na innym serwerze. Główna baza obsługuje bieżące operacje, a replikowana – raporty i analitykę. Dzięki temu analizy nie spowalniają systemu produkcyjnego, a dane są dostępne „na świeżo”.

To rozwiązanie okazało się konieczne, bo liczba transakcji rośnie z roku na rok. Kiedyś karty były rzadkością, dziś płacimy nimi wszędzie. Do tego doszedł BLIK i płatności telefonem. Biznes się zmienia, technologie się rozwijają, a systemy muszą nadążać. Skalowalność to nie tylko więcej danych – to elastyczność, podział zadań i gotowość na rozwój.

Hurtownia danych – czyli jak śledzić zmiany, których nie widać na pierwszy rzut oka

Hurtownia danych działa podobnie jak replikacja, z tą różnicą, że nie w czasie rzeczywistym. Dane trafiają tam zwykle raz dziennie – cyklicznie, w ustalonych odstępach. To wystarcza, bo hurtownia służy do innego typu analiz niż system produkcyjny. Nie chodzi w niej o szybkość, tylko o możliwość śledzenia zmian w czasie.

Przykład? Status karty – aktywna lub nieaktywna. W systemie produkcyjnym widzisz tylko bieżący stan. Dziś karta jest aktywna. Jutro – nadal aktywna. I pojutrze też. Aż pewnego dnia wchodzisz i widzisz: karta nieaktywna. Ale… kiedy dokładnie ten status się zmienił? Tego system już ci nie powie – bo nie trzyma historii zmian, tylko pokazuje to, co jest „tu i teraz”.

I właśnie tu wchodzi hurtownia danych. Jeśli codziennie zapisuje taki status, to buduje z czasem całą historię. Dzień po dniu: aktywna, aktywna, aktywna… aż nagle: nieaktywna, nieaktywna… a potem znowu: aktywna. Dzięki temu można łatwo ustalić, że karta była np. nieaktywna przez dwa dni – i dokładnie kiedy to miało miejsce. Taka analiza nie jest możliwa na danych z systemu produkcyjnego.

Podobnie z saldem. Jeśli nie masz historii rachunku, tylko patrzysz na aktualne saldo, to widzisz po prostu jakąś wartość. Za godzinę może być inna, jutro inna, za tydzień jeszcze inna. A co, jeśli chcesz wiedzieć, jakie było twoje średnie saldo w miesiącu? Bez historii się nie da. Ale jeśli hurtownia codziennie zapisywała to saldo – możesz to łatwo policzyć. Bierzesz wszystkie wartości, dzielisz przez liczbę dni – i masz odpowiedź.

To pokazuje, że hurtownia danych daje możliwość skalowania „w czasie” danych, które na pierwszy rzut oka wydają się niezmienne. Wcale nie dodajesz nowych danych – dodajesz wymiar czasu. I nagle możesz spojrzeć na te same informacje z zupełnie innej perspektywy.

To też sposób na skalowanie – niekoniecznie przez większy wolumen, ale przez większą głębię analizy. Dane plus czas to zupełnie inna jakość.

Podsumowanie

Skalowalne dane to skalowalny biznes! Dbanie o skalowalność danych jest podstawą budowania nowoczesnej i przyszłościowej infrastruktury IT. Pozwala firmom coraz lepiej zarządzać coraz większą ilością informacji. To także wsparcie dla nowoczesnych rozwiązań, takich jak sztuczna inteligencja, jak również sposób na utrzymanie przewagi nad konkurencją. W skalowaniu danych pomaga konteneryzacja i orkiestracja, a w sektorze bankowym – replikacja i hurtownia danych.

Jeśli inwestujesz w skalowalność danych, inwestujesz tak naprawdę w przyszłość twojej firmy. Chcesz zadbać o jakość lub bezpieczeństwo danych w swojej organizacji? Umów spotkanie z Jackiem!